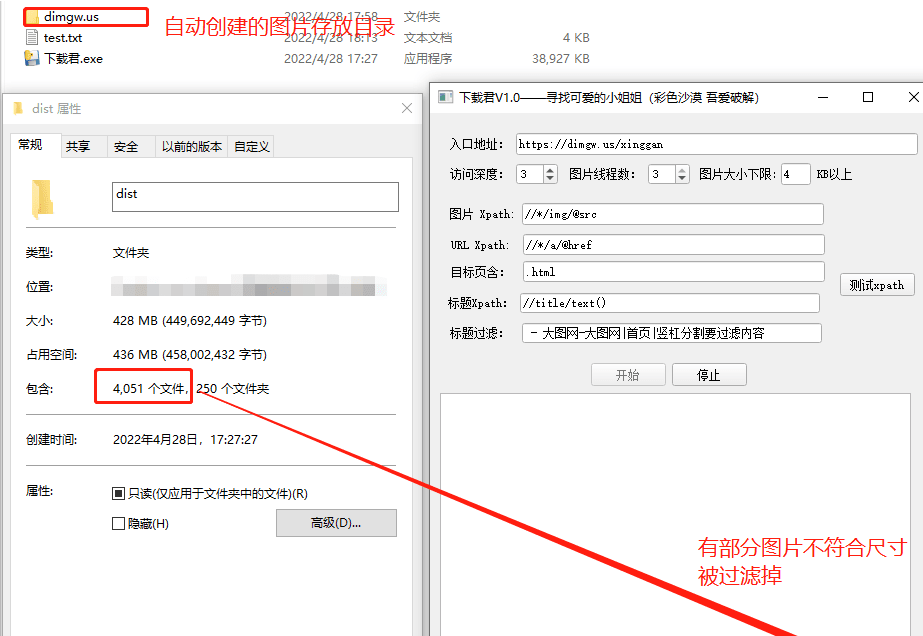

下载君这个是网友原创的一个工具,是一个能自动寻找并爬取漂亮小姐姐图片的下载利器,一个通用的图片下载器,能够自动识别网址,将大家想要的图片识别过滤出来,还可以免费下载下来。

工具介绍

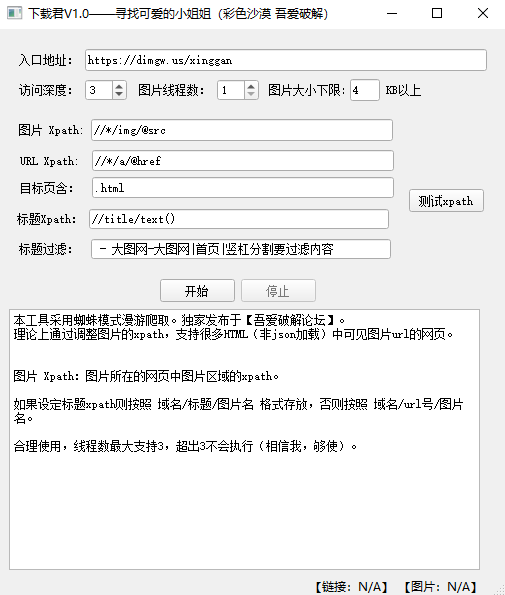

我的宗旨是你只要提供一个网址,剩下的交给我!

下载君能下美女图片、壁纸图片、头像图片等等,只要是图的,尽量争取都能下载,是一款有一定通用性的图片下载利器。

下载君会自动发现给定目标网址所在的网站的页面,不会跑到站外去的。

下载君使用教程

访问深度:不要设置太高,因为这东西是超级指数型增长的,比如设置3,就能发现几千新页面(网站不同,这个也不同)。

图片线程:也不要太高,够用就行,高了一方面对网站不友好,另一方面则有可能因为访问频次太高而被Ban掉,得不偿失。要以时间换空间。

工具只需要正确配置网页元素的xpath就可以愉快的运行了,所以重点还是介绍一下如何正确使用xpath。

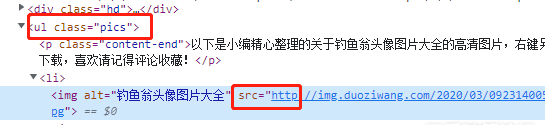

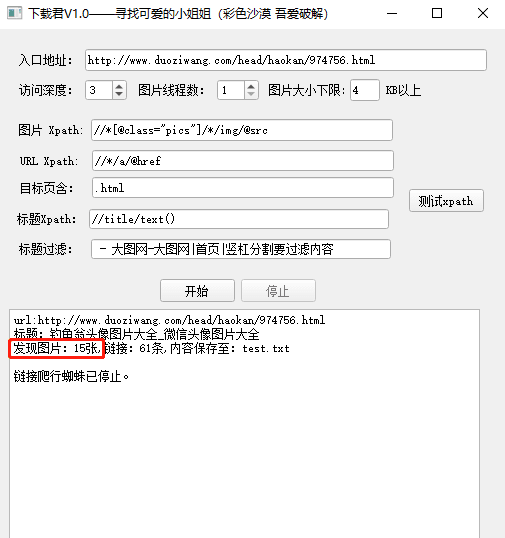

使用chrome浏览器打开网页,可以看到我们想要的文章内部图片一共15张,其他图片不是我们要的。

在目标图片上右键,选择【检查】,打开网页元素页面:

在元素上,右键>copy>copy xpath,如下图:

我们将得到这么一条xpath:

//*[@id="syno-nsc-ext-gen3"]/div[3]/div[3]/div[1]/div[1]/ul/li[7]/img

可以看到他是按照html的网页结构一层一层定位到这张img的元素上的,而我们需要所有元素怎么办呢?

我们往上一级查看,图片在<li>中,<li>在<p>中,而<ul>中有2个<p>,图片所在的<p>是第一个。

因此,改造一下xpath:

//*[@class="pics"]/*/img

意为寻找class属性为pics的元素其内部的img元素。至于前后的*表示任意层级。

找到元素后,我们需要获知的是其src属性值(图片地址),于是图片的xpath就变成了:

//*[@class="pics"]/*/img/@src

我们测试一下,成功发现15张图片,如下图:

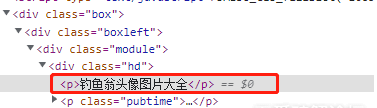

至于标题,可以默认不变,会找网页整个的标题,此时配合【标题过滤】可以剔除一部分通用的文字,但如果想要更加精确,就需要准确找到其大标题了

如上图,标题所处的元素是<p>内,其在<div class='hd'>下,而这个div内部有2个p,我们选第一个。而我们要的是<p>内的文字,因此要加text()方法,最终如下:

//*[@class="hd"]/p[1]/text()

更新日志

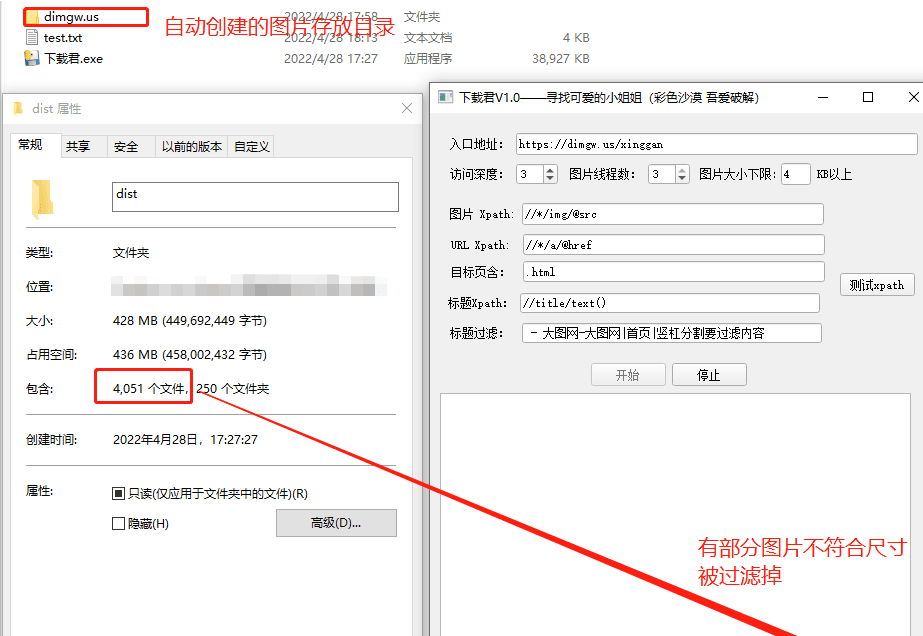

1、支持定义蜘蛛访问深度。

2、支持定义图片线程。

3、支持图片尺寸过滤。

- PC官方版

- 安卓官方手机版

- IOS官方手机版

下载

下载  下载

下载  下载

下载  下载

下载  下载

下载  下载

下载  全能瞳下载器(Hitomi Downloader)1.0.0 最新版

全能瞳下载器(Hitomi Downloader)1.0.0 最新版

TVBOX助手免安装版1.0.9 最新版

TVBOX助手免安装版1.0.9 最新版

speed百度网盘极速版1.0.0 免费版

speed百度网盘极速版1.0.0 免费版

腾讯应用宝电脑版1.0.0.0 最新版

腾讯应用宝电脑版1.0.0.0 最新版

漫画下载器无广告v1.1.0 最新版

漫画下载器无广告v1.1.0 最新版

喜马拉雅音频下载软件0.02 最新版

喜马拉雅音频下载软件0.02 最新版

XX文库下载器精简版3.4 最新版

XX文库下载器精简版3.4 最新版

小白云盘pc端(64位)1.0.4.2 最新版

小白云盘pc端(64位)1.0.4.2 最新版

蜗牛云盘Windows版(阿里云盘电脑播放器)1.3.4 pc端

蜗牛云盘Windows版(阿里云盘电脑播放器)1.3.4 pc端

小白羊云盘PC版3.11.5 最新版

小白羊云盘PC版3.11.5 最新版

B站视频下载器(BilibiliVideoDownload)v3.3.3 最新版

B站视频下载器(BilibiliVideoDownload)v3.3.3 最新版

鼠鼠下载器(B站视频下载工具)1.1.1 最新版

鼠鼠下载器(B站视频下载工具)1.1.1 最新版

XX文库下载器电脑版1.3 吾爱破解

XX文库下载器电脑版1.3 吾爱破解

uTorrent Pro绿色版3.5.5.46348 最新版

uTorrent Pro绿色版3.5.5.46348 最新版

4K Video Downloader(4K视频下载器)v4.21.0 绿色中文版

4K Video Downloader(4K视频下载器)v4.21.0 绿色中文版

闪豆视频下载器免安装版(多平台视频批量下载器)3.7.0 免费版

闪豆视频下载器免安装版(多平台视频批量下载器)3.7.0 免费版

MusicThief(付费歌曲免费下载软件)v2.1.0.0 免安装绿色版

MusicThief(付费歌曲免费下载软件)v2.1.0.0 免安装绿色版

文件蜈蚣下载器2.02 最新版

文件蜈蚣下载器2.02 最新版

蜻蜓fm批量下载工具1.1.3 免费版

蜻蜓fm批量下载工具1.1.3 免费版

闪豆视频下载器20233.7.0 最新版

闪豆视频下载器20233.7.0 最新版

伪pandownload公测版1.18.0 电脑版

伪pandownload公测版1.18.0 电脑版

迅雷11正式版11.4.1.2030 官方最新版【离线版】

迅雷11正式版11.4.1.2030 官方最新版【离线版】

flashfxp中文版下载5.4.0.3970 已注册免费版

flashfxp中文版下载5.4.0.3970 已注册免费版

够快云库客户端5.2.5.11010 官方最新版

够快云库客户端5.2.5.11010 官方最新版

Motrix下载器1.6.11 电脑最新版

Motrix下载器1.6.11 电脑最新版

迷你纯净版迅雷(迅雷精简版)1.5.2.288 便携安装版

迷你纯净版迅雷(迅雷精简版)1.5.2.288 便携安装版

HmDX很萌下载器(m3u8视频下载助手)5.6.0 最新更新版

HmDX很萌下载器(m3u8视频下载助手)5.6.0 最新更新版

马蜂窝原图批量下载工具1.0 绿色免费版

马蜂窝原图批量下载工具1.0 绿色免费版

蒲公英windows客户端1.0.2 官方最新版

蒲公英windows客户端1.0.2 官方最新版

FileZilla(支持断点续传的FTP客户端)3.51.0 中文免费版

FileZilla(支持断点续传的FTP客户端)3.51.0 中文免费版

蓝奏云外链批量下载软件1.0 最新版

蓝奏云外链批量下载软件1.0 最新版

七牛云图床一键下载工具1.0 绿色中文版

七牛云图床一键下载工具1.0 绿色中文版

视频下载高手57.1免费版

视频下载高手57.1免费版

EagleGet(猎鹰下载器)2.1.5.20中文最新版

EagleGet(猎鹰下载器)2.1.5.20中文最新版

冰点文库下载器3.2.10(1021) 官方版

冰点文库下载器3.2.10(1021) 官方版

啄木鸟图片下载器标准版11.28.1官方版

啄木鸟图片下载器标准版11.28.1官方版

火狐浏览器下载器Firefox Download Tool1.5.0.23汉化版

火狐浏览器下载器Firefox Download Tool1.5.0.23汉化版

QQ相册批量下载器(QQ空间相册下载)8.0 绿色免注册版

QQ相册批量下载器(QQ空间相册下载)8.0 绿色免注册版

internet download manager 6.41.6破解版中

internet download manager 6.41.6破解版中 P2pSearcher(种子搜索神器)8.0.2绿色无广告

P2pSearcher(种子搜索神器)8.0.2绿色无广告 Downkyi哔哩下载姬(b站视频下载工具)1.5.9

Downkyi哔哩下载姬(b站视频下载工具)1.5.9  Neat Download Manager下载器汉化版1.3.10.

Neat Download Manager下载器汉化版1.3.10.